LSTM: Difference between revisions

From CS Wiki

No edit summary |

(→구성 요소) |

||

| (3 intermediate revisions by the same user not shown) | |||

| Line 5: | Line 5: | ||

;RNN의 수식 표현 h<sub>t</sub> = f<sub>W</sub>(h<sub>t-1</sub>, x<sub>t</sub>) | ;RNN의 수식 표현 h<sub>t</sub> = f<sub>W</sub>(h<sub>t-1</sub>, x<sub>t</sub>) | ||

* 문장 구성 수 만큼 Hidden Layer 형성하여 매우 Deep한 구조 | * 문장 구성 수 만큼 Hidden Layer 형성하여 매우 Deep한 구조 | ||

* Recurrent에 따른 동일한 가중치(f<sub>W</sub>)가 곱해지게 되므로 아래 문제 발생 | ** Recurrent에 따른 동일한 가중치(f<sub>W</sub>)가 곱해지게 되므로 아래 문제 발생 | ||

* f<sub>W</sub> < 1 인 경우, '''Vanishing Gradient''' | * f<sub>W</sub> < 1 인 경우, '''Vanishing Gradient''' | ||

* f<sub>W</sub> > 1 인 경우, '''Exploding Gradient''' | * f<sub>W</sub> > 1 인 경우, '''Exploding Gradient''' | ||

* 즉, 관련 정보와 그 정보를 사용하는 지점이 먼 경우 학습 능력 저하 | * 즉, 관련 정보와 그 정보를 사용하는 지점이 먼 경우 학습 능력 저하 | ||

** 장기 기억을 사용하지 못하고 단기 기억만을 사용 | ** 장기 기억을 사용하지 못하고 단기 기억만을 사용 | ||

* '''LSTM(Long Short Term Memory)는 이 문제를 해결''' | |||

[[파일:RNN vs LSTM Cell State 개념도.png]] | |||

== 구성 요소 == | == 구성 요소 == | ||

[[파일:LSTM 개념도.png|600px]] | |||

{| class="wikitable" | {| class="wikitable" | ||

|- | |- | ||

Latest revision as of 22:25, 25 January 2020

- Long Short Term Memory

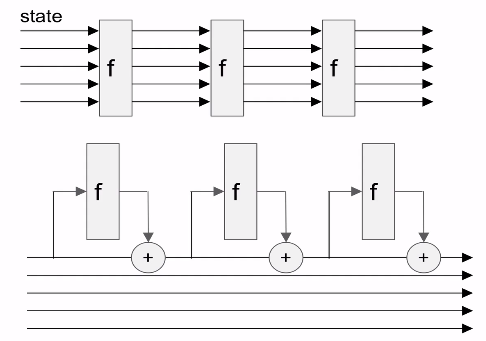

RNN의 문제[edit | edit source]

- RNN의 수식 표현 ht = fW(ht-1, xt)

- 문장 구성 수 만큼 Hidden Layer 형성하여 매우 Deep한 구조

- Recurrent에 따른 동일한 가중치(fW)가 곱해지게 되므로 아래 문제 발생

- fW < 1 인 경우, Vanishing Gradient

- fW > 1 인 경우, Exploding Gradient

- 즉, 관련 정보와 그 정보를 사용하는 지점이 먼 경우 학습 능력 저하

- 장기 기억을 사용하지 못하고 단기 기억만을 사용

- LSTM(Long Short Term Memory)는 이 문제를 해결

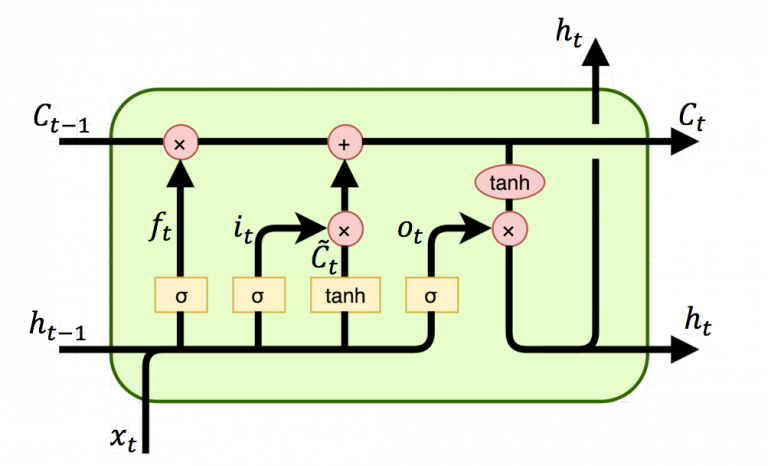

구성 요소[edit | edit source]

| 구성 요소 | 설명 |

|---|---|

| Forget Gate Layer |

|

| Input Gate Layer |

|

| Update Cell State |

|

| Output Gate Layer |

|