ReLU: Difference between revisions

From CS Wiki

(새 문서: 분류:인공지능 ;ReLU(Rectified Linear Unit), 릴루 또는 렐루라고도 한다. == 개요 == * 음수 값은 무시하여 0으로 취하고, 양수 값은 그대로 취...) |

No edit summary |

||

| (One intermediate revision by one other user not shown) | |||

| Line 4: | Line 4: | ||

== 개요 == | == 개요 == | ||

* 음수 값은 무시하여 0으로 취하고, 양수 값은 그대로 취하는 활성화 함수 | * 음수 값은 무시하여 0으로 취하고, 양수 값은 그대로 취하는 활성화 함수 | ||

* y = max(z,0) | |||

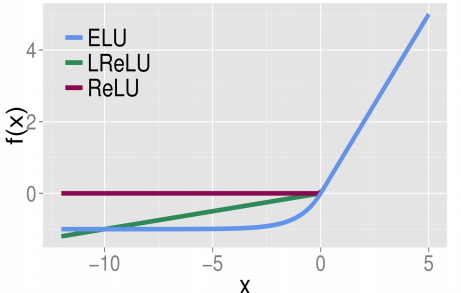

== | == 종류 == | ||

* | [[파일:Relu.jpg]] | ||

* ReLU | |||

* Leaky ReLU | |||

* ELU(Exponential linear Unit) | |||

Latest revision as of 08:28, 3 January 2020

- ReLU(Rectified Linear Unit), 릴루 또는 렐루라고도 한다.

개요[edit | edit source]

- 음수 값은 무시하여 0으로 취하고, 양수 값은 그대로 취하는 활성화 함수

- y = max(z,0)

종류[edit | edit source]

- ReLU

- Leaky ReLU

- ELU(Exponential linear Unit)